【项目实战】基于跨域学习的行人重识别

基于域学习的行人重识别

项目描述

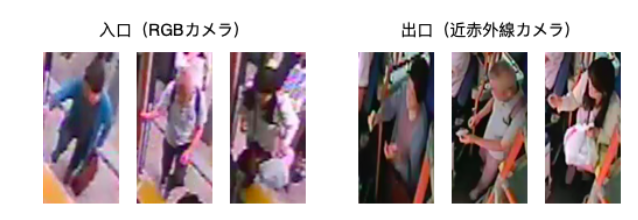

偏工业项目。主要针对解决公交车的出入口行人重识别课题,来达到自动判断乘客的乘车区间的目的。难点有三:1. 本数据集的出入口的摄像机种类不同(RGB和近红外线) 2. 为保护隐私分辨率较低无法使用面部特征 3. 外部光照影响较大。数据集来源为日本公交公司。

基本思路

难点的关键在于我们无法使用过去的方法:颜色特征和面部特征。因此解决的关键是实现提取颜色光照无关的特征(更深层的特征,或域无关的特征)。考虑了以下三种解决方法:

- 利用深度网络学习域无关特征(DANN,AGW)

- 手动提取域无关特征(HeadReID)

- 姿态估计(TODO)

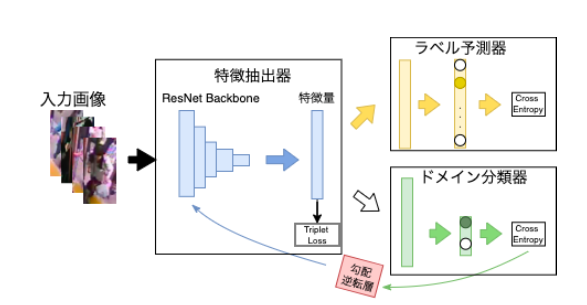

DANN [1]

在一般的分类预测期以外加上了域分类器,以提高特征的抽象度。我们希望提取出的特征无法被域分类器成功判别,以确认生成的特征是域无关的。

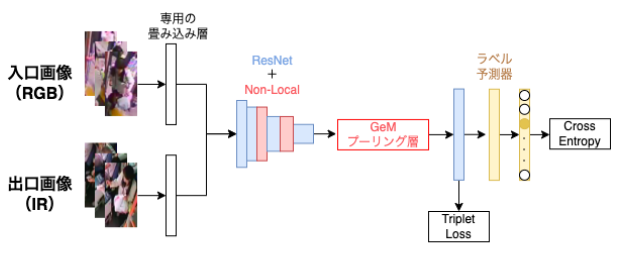

AGW [2]

考虑到表层特征差异大的问题,还尝试了通过分开卷积层的方法。首先使用域单独的卷积层提取出表层特征,再进入相同的Resnet+NoLocal块的网络,增加对全域特征的提取能力。

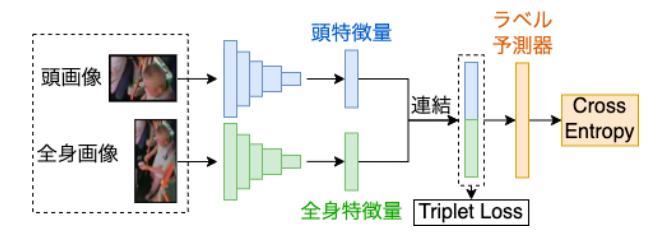

HeadReID

根据文献 [3],仅仅是头部特征也有惊人的表达能力。因此尝试了增加提取头部特征的网络,以抵御域变换带来的影响。

实现过程

主要为以下步骤:

- 数据处理:视频转换为图片,根据真值切割出每一帧的正确的行人图片,为每个行人制作文件夹,形成最后的数据库

- 对于HeadReID使用的头部图片由于没有真值,简单的利用原行人图片的上部20%进行提取。

DANN:两个域的行人图片集分别传入Resnet50,提取出特征向量。利用此特征向量分别进行:

- 度量学习:Triplet Loss

- 标签预测:Person ID预测 → label loss

域预测:属于入口/出口 → domain loss → 梯度翻转 → ${y(domain loss)}$

三个loss之和最小化

AGW:两个域的行人图片集分别传入各自的特征提取层。最小化分类损失。

HeadReID:行人图片集及其头部图片分别传入对应的特征提取网络。最小化分类损失。

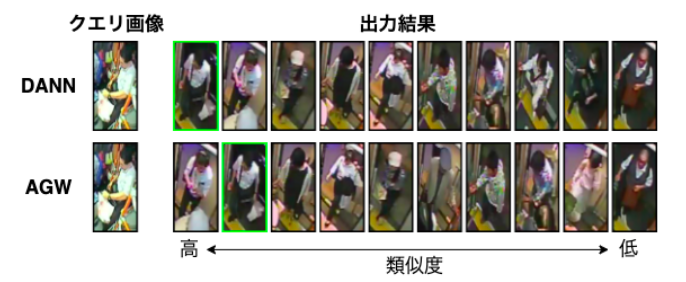

使用测试集,求出两两行人图片之间的特征类似度,得出结果。

参数选择

根据实验,使用sin函数作为类似度函数,以及对于每个ID的行人使用所有图片的平均特征量时效果过最好。

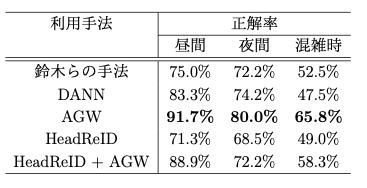

实验结果

最终结果说明,AGW的手法在里面的效果最好。尤其在人多时造成特征不完全时带来的收益最大。但是当有明显的局部特征如帽子耳机等时,DANN对其的学习能力更强。

HeadReID的失败原因:

- 虽然头部特征在前手法中论证有用,但实际本数据集的分辨率远远低于文献使用的数据集。

- 因为没有使用头部识别网络而仅仅进行了剪裁操作,衣服等域有关的特征不可避免的被混入。

- 数据集中有儿童的存在:他们无法使用简单的剪裁操作生成头部图片。

参考文献

[1] Y. Ganin and V. Lempitsky. Unsupervised domain adaptation by backpropa- gation. In ICML, Vol. 37, pp. 1180–1189, 2015.

[2] M. Ye, J. Shen, G. Lin, T. Xiang, L. Shao, and S. C. H. Hoi. Deep Learning for Person Re-identification: A Survey and Outlook. TPAMI, pp. 1–1, 2021. doi:10.1109/TPAMI.2021.3054775.

[3] Junliang Guo, Yanbing Xue, Jing Cai, Zan Gao, Guangping Xu, and Hua Zhang. A bus passenger re-identification dataset and a deep learning baseline using triplet embedding. Multimedia Tools and Applications, Vol. 80, No. 11, pp. 16425–16440, 2021.